CNO Validation Framework

Informationen werden mehr und mehr zur Basis von wichtigen Unternehmensentscheidungen. Doch das funktioniert nur, wenn die zugrunde liegenden Daten korrekt und vollständig sind. Ansonsten droht das bekannte „Garbage in – Garbage out“. Unternehmen müssen sich deshalb verstärkt um Data-Governance und Datenqualität kümmern. Mit dem Validation Framework bietet CAD ’N ORG ein mächtiges Werkzeug zur Sicherstellung der Datenkonsistenz und Qualität im PLM-System Teamcenter.

Ziele

- Vermeidung inkonsistenter Daten schon bei der Entstehung

- Identifikation von unvollständigen oder veralteten Informationen

- Schnellere Prozessabläufe und bessere Datenqualität im PLM-System

Funktionen

- Vorab-Validierung durch den Anwender über Assistenten

- Integration in beliebige Anwendungen und existierende Workflow Prozesse

- Definition von Regeln und Prüfkriterien in Teamcenter

- Prüfmöglichkeiten auf Einzel- und Baugruppenebenen in unterschiedlicher Tiefe

- Analysefunktion zur Sicherstellung der Datenqualität

- Validierung von Alt-Daten oder migrierten Daten

- Reportfunktionalität mit Anbindungsmöglichkeit an bestehende Reporting-Lösungen

- Bereinigungsfunktionalität von fehlerhaften Daten

Systemanforderung

- Teamcenter (andere PLM-Systeme auf Anfrage)

- Linux und Windows Support

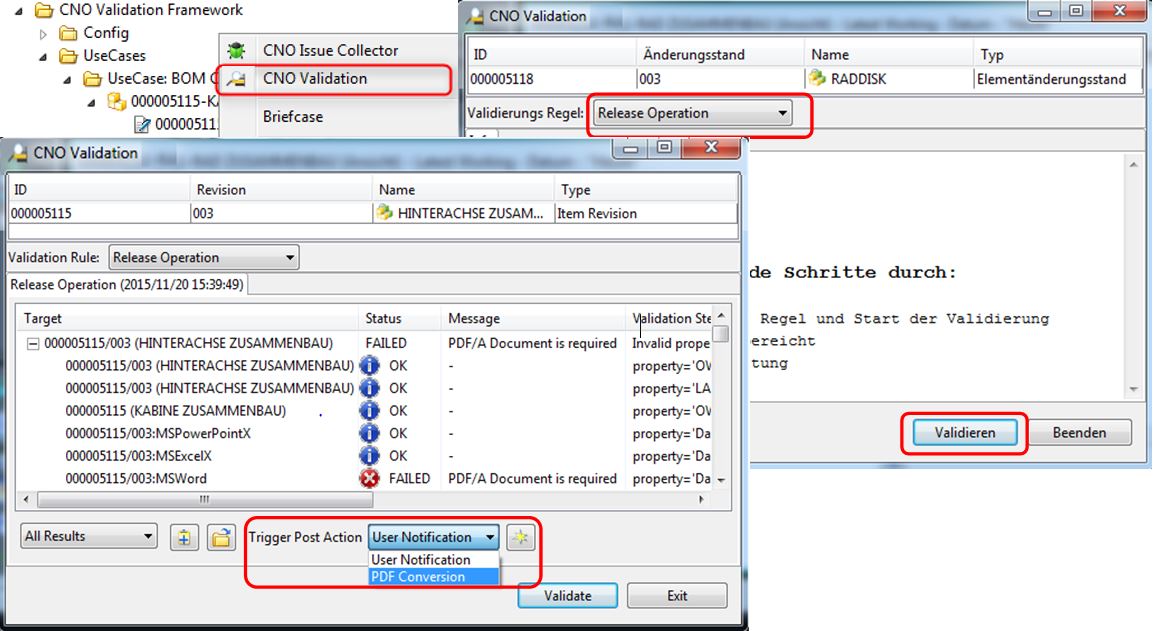

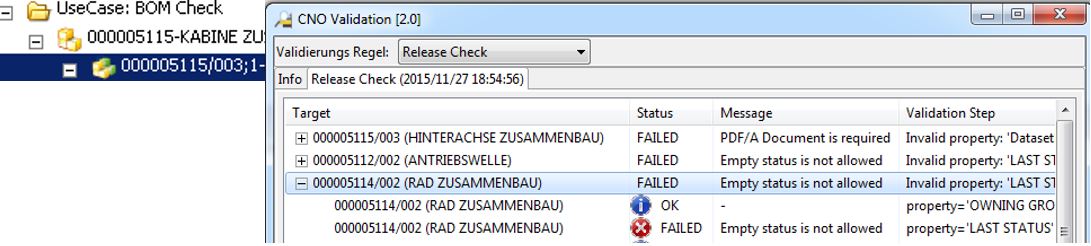

Beispiel: Teamcenter Rich Client Integration

Sicherstellung der Daten- und Prozessqualität durch integrierten Assistenten

Prozesssicherheit und exzellente Datenqualität mittels Validation Framework

Ad-Hoc Prüfungen

- Vorab-Validierung durch den Anwender vor Einleitung des Freigabe-Prozesses

- Start von Folgeverarbeitung im Gut- und Fehlerfall

- Training der Anwender auf firmeninterne Qualitätsanforderungen

Workflow Prüfungen

- Integration der Überprüfung in existierende Workflows

- Rekursive Prüfung von Stücklisten mittels Expansion- und Laderegeln

- Prüfungen in beliebigen Prozessschritten und geringere Workflow Komplexität

Eingabe Prüfungen

- Vermeidung der Anlage von ungültigen Objekten

- Hinweise zur korrekten Ausfüllung von Formularen

- Erkennung von Duplikaten

- Integration in alle PLM Komponenten (Datenmodel, CAD, Interfaces, …)

Reports

- Query-Engine zur Bereitstellung von Daten an BI-Systeme für weitere Analysen und zur Initiierung von Verbesserungsmaßnahmen

- Report-Engine zur Aufbereitung in unterschiedliche Formate

Sammelkorrekturen

- Bereinigung von fehlerhaft oder unvollständig migrierten Daten

- Identifikation und Korrektur von Alt-Daten

- Schnelle und einfache Integration in beliebige Arbeitsprozesse

Konfigurationsassistent

- Einfache Anlage von Prüfregeln über Assistenten in Teamcenter

- Abbildung von komplexen Regeln per Drag&Drop

- Direkter Zugriff aufs Teamcenter Datenmodel ohne großen Einarbeitungsaufwand

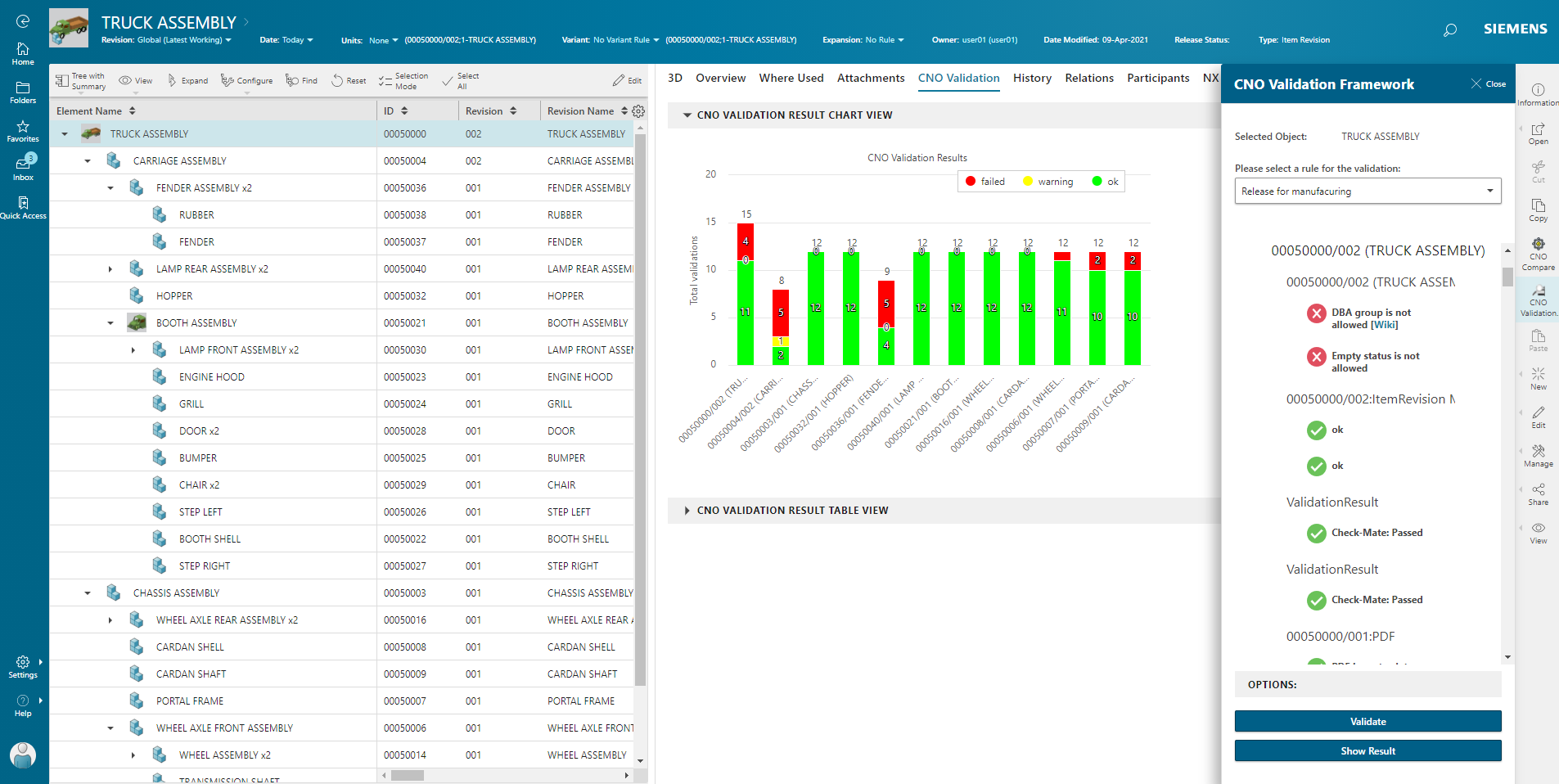

Beispiel: Active Workspace Integration

Sicherstellung der Daten- und Prozessqualität durch tiefe Integration in alle Module und Schnittstellen

Handhabung

Das Validation Framework fügt sich nahtlos in die existierende Umgebung ein und ist einfach bedienbar. Die Validierung erfolgt Ad-Hoc durch den Anwender, als Vorab-Prüfung im Rich Client / Active Workspace, automatisch integriert im Freigabe-Workflow oder als proaktive Fehlersuche im aktuellen Datenbestand. Die Kriterien der Validierung sind frei konfigurierbar und können an wachsende Anforderungen angepasst werden.

Ergebnis / Nutzen

- Hohe Akzeptanz der Anwender durch eigenständige Fehlerkorrekturen

- Fehlerfreie Daten und effiziente Workflow Prozesse

- Schnellere Abläufe in Teamcenter durch Fehlervermeidung

Weitere Vorteile

- Die Validierungslösung gewährleistet bei systematischer Anwendung einen fehlerfreien/konsistenten Datenbestand im Teamcenter.

- Korrekturmaßnahmen werden standardisiert und einheitlich durchgeführt. Abbrüche in nachfolgenden Prozessen wie Fertigungsfreigaben oder Datenübernahmen zum ERP werden verhindert.

- Risiken durch die Verwendung ungültiger oder veralteter Informationen in nachfolgenden Geschäftsprozessen werden vermieden.

- Laufende Weiterentwicklung der Prüfkriterien führen zum langfristig effizienten und fehlerfreien Arbeiten in Teamcenter.

Anforderungen an ein professionelles Datenmanagement in Teamcenter

Entwicklungsprozesse werden in Teamcenter durch Workflows abgebildet, Daten und Modelle werden hierdurch erzeugt, verändert, freigegeben und anschließend an ERP-Systeme wie SAP zur weiteren Verwendung übergeben.

Effizientes Arbeiten durch exzellente Datenqualität

Effizientes Arbeiten in Teamcenter erfordert „Datenqualität“, d.h. die konsequente Einhaltung der Design-Standards, als Voraussetzung für fehlerfrei durchlaufende Prozesse.

Aufwand für Fehlerkorrekturen in Teamcenter

Die von Teamcenter ausgegebenen Standard-Fehlermeldungen geben oft wenig Hinweise auf den Entstehungsgrund und -ort. Korrekturen müssen meist vom IT-Helpdesk durchgeführt werden, sind häufig kompliziert, zeitaufwendig und wiederkehrend durchzuführen.

Fazit

Ohne die systematische Verbesserung der Datenqualität durch professionelle Werkzeuge steigt der administrative Aufwand für Korrekturen mit der Datenmenge kontinuierlich an, das Arbeiten in Teamcenter wird für den Anwender immer komplexer und unübersichtlicher.

Demo Active Workspace:

Im Video sehen Sie unsere Lösung eingebettet im Active Workspace für die interaktive Validierung.

Demo Rich Client:

Im Video sehen Sie unsere Lösung als Rich Client Anwendung für die interaktive Validierung.